Wissenschaftler der Uni Osnabrück Co-Autor für Artikel in „Nature Machine Intelligence“

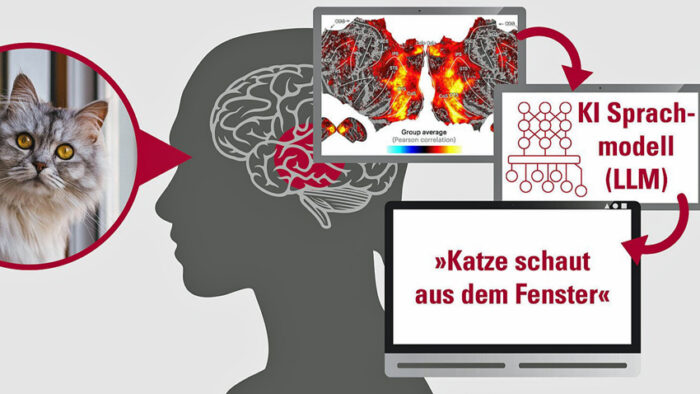

Zum Hintergrund der Studie: Wenn wir die Welt um uns herum betrachten, erkennt unser Gehirn nicht nur Objekte wie „Hund“ oder „Auto“, sondern versteht auch übergeordnete räumliche, semantische Zusammenhänge – was geschieht, wo es geschieht und wie alles zusammenpasst.

Diese Informationen sind essentiell für unser Verständnis des menschlichen Sehens, doch bisher fehlten Wissenschaftlerinnen und Wissenschaftlern die Werkzeuge, um diese komplexen Vorgänge zu analysieren.

“Sprachmodelle zum Verständnis visueller Verarbeitung zu nutzen klingt zunächst unsinnig”, erklärt Prof. Dr. Tim C. Kietzmann von der Uni Osnabrück und Co-Erstautor der Studie. “Allerdings sind Sprachmodelle extrem gut darin, kontextuelle Informationen zu verarbeiten, und haben ein gleichzeitig semantisch reichhaltiges Verständnis von Objekten und Aktionen. Das sind wichtige Zutaten, die auch das visuelle System extrahieren könnte, wenn es mit natürlichen Szenen konfrontiert ist.”

Und in der Tat: sprachliche Szenenbeschreibungen, dargestellt in großen Sprachmodellen, sogenannten Large Language Models, weisen erstaunliche Ähnlichkeiten zu Hirnaktivität im visuellen System auf, während Probanden die entsprechenden Bilder in einem Magnetresonanztomographen anschauen. Könnte es also sein, dass das visuelle System des menschlichen Gehirns als Aufgabe hat, visuelle Eindrücke so zu verarbeiten, dass sie kompatibel mit Sprache sind? “Es ist denkbar, dass das Gehirn über verschiedene Sinne und Sprache hinweg versucht, eine einheitliche Sprache, eine lingua franca, zu finden. Dies würde den Austausch zwischen Hirnarealen extrem vereinfachen“, so Prof. Dr. Adrien Doerig, der mittlerweile an der FU Berlin forscht.

Die Forschenden gingen noch einen Schritt weiter: Sie trainierten künstliche neuronale Netze, welche in einem mehrstufigen Verfahren aus Bildern korrekte Sprachmodell-Repräsentationen vorhersagen können. Diese Modelle, welche visuelle Informationen dahingehend verarbeiten, dass sie sprachlich dekodierbar sind, können die Hirnaktivität der Probanden besser abbilden, als viele der derzeit führenden KI-Modelle im Feld.

Die überraschende Übereinstimmung von Repräsentationen in KI-Sprachmodellen und Aktivierungsmustern im Gehirn ist nicht nur von Bedeutung für unser Verständnis komplexer semantischer Verarbeitung im Gehirn, sondern zeigt gleichzeitig auch mögliche Pfade auf, wie KI-Systeme in Zukunft verbessert werden können. Auch medizinische Anwendungen sind denkbar. So gelang es dem Forscherteam ebenfalls, mit Hilfe von KI akkurate Beschreibungen der Bilder zu generieren, die die Probanden im Hirnscanner anschauten.

Dieses Gedankenlesen weist auf mögliche Verbesserungen für Gehirn-Computer-Schnittstellen hin. Andersherum könnte diese neue Technologie eines Tages auch zur Entwicklung visueller Prothesen für Menschen mit starken Sehbeeinträchtigungen beitragen.

Zum Paper : Adrien Doerig et al., High-level visual representations in the human brain are aligned with large language models, Nature Machine Intelligence (2025).